Indexation & Crawl Google : kézako ? comment être indéxé ?

Indispensable pour rendre son site visible 🦦

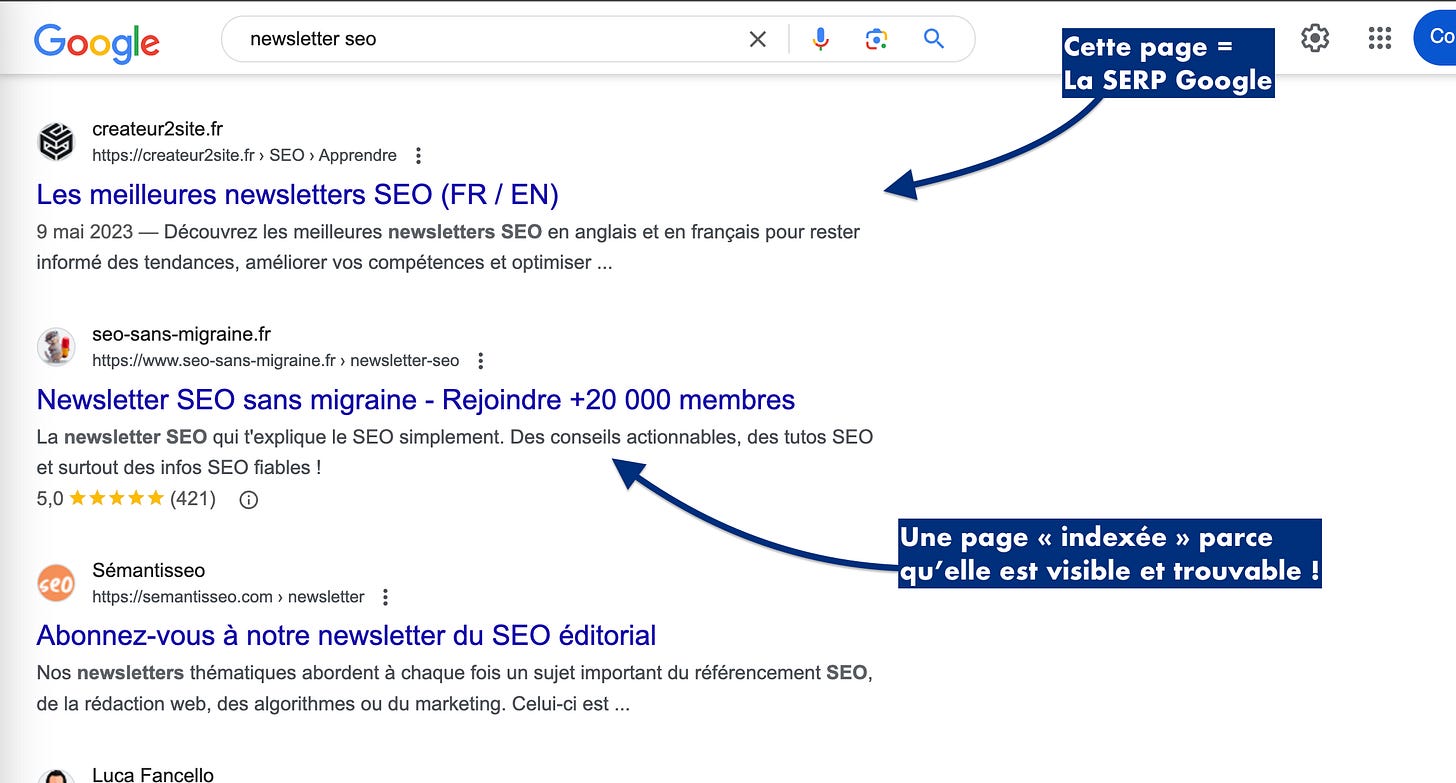

L'indexation, c'est le processus par lequel Google découvre, analyse et stocke les pages de ton site pour les rendre visibles sur son moteur de recherche. Enfin plus précisément dans ce qu’on appelle "la SERP”. 👀

SERP = C’est la page de résultats après avoir tapé un mot-clé :

Pour comprendre l’indexation, imagine que c'est comme l'enregistrement de ton site dans la grande bibliothèque de Google. 📚

-

Pourquoi c’est crucial ?

Sans indexation, tes pages n'existent tout simplement pas pour Google. Peu importe la qualité de ton contenu ou tes backlinks. C'est la 1ʳᵉ étape pour que ton site apparaisse dans les résultats de recherche.

Sinon tu finis dans les abysses de Google. ☠️

En moyenne, jusqu'à 20% des pages d'un site peuvent ne pas être indexées par Google.

Les raisons sont multiples : problèmes techniques, mauvaise qualité, mauvaise fiabilité. Majoritairement c'est à cause de ce qu'on appelle les "core web vitals".-

Comment Google indexe-t-il des sites ?

Google utilise des robots, appelés Googlebots, qui crawlent (on revient sur cette notion un peu plus tard) le web pour trouver de nouvelles pages à ajouter à son index. Ils suivent les liens d'une page à l'autre, et collectent des données sur chaque page qu'ils visitent.

“Suivent les liens d’une page à l’autre..” Mmh ça te dit quelque chose ? 😏

→ Les liens internes ! Ils jouent un rôle crucial ici puisque ce sont tes liens internes qui relient tes pages comme une énorme toile d’araignée. 🕸️

🦦 Loutrastuce : ton site doit être bien structuré - tu dois faciliter la navigation pour que les ptits robots de Google puissent découvrir facilement toutes les pages ! Un sitemap propre est ton meilleur ami ici ! 👈

-

Est-ce que cela peut être un choix de ne pas indexé certaines pages de mon site ?

Figure toi que oui ! 🦦 Par exemple :

Pages de remerciement : Après qu'un utilisateur s'inscrit ou achète quelque chose. Ces pages ne sont pas destinées à être trouvées sur Google, donc aucune raison de les indexer.

Contenu en double : Pour éviter les problèmes de cannibalisation, ça peut être une technique de ne pas indexer certaines pages qui reprennent le même contenu que d'autres déjà indexées. 🤷🏼♀️

Pages internes : Les pages utilisées pour la gestion interne d'un site, comme des pages de configuration ou des bases de données utilisateurs.

Contenu en développement : Les pages en cours de construction ou celles utilisées pour tester de nouvelles fonctionnalités. ⚙️

Contenu sensible ou privé : Certaines informations destinées à un public restreint ou qui sont sensibles en nature ne devraient pas être indexées pour des raisons de confidentialité ou de sécurité.

Au fait, j’en profite pour te parler de la nouvelle plateforme de LinksGarden. Tu peux trouver tes backlinks à un prix sans migraine (et avec des liens quali!) :

-

Comment ne pas indexer certaines pages ?

Il existe pas mal de méthodes pour ne pas indexer certaines pages qui diffèrent selon le CMS que tu utilises (exemple : Wordpress). Je te donne une petite liste non-exhaustive :

Utiliser le fichier

robots.txtLe fichier

robots.txtest utilisé pour donner des instructions aux robots des moteurs de recherche sur quelles parties de ton site ils peuvent ou ne peuvent pas scanner. (C’est un peu le GPS de ton site tu vas indiquer à Google les routes qu’il peut ou ne peut pas prendre pour cause de travaux, déviations temporaires, suppressions de routes…).Utiliser la balise

Meta NoindexPlace une balise Meta Noindex dans le

<head>de tes pages HTML pour dire aux moteurs de recherche de ne pas indexer ces pages.Ajoute des plugins à WordPress

Sur YoastSEO ou RankMath par exemple, tu pourras facilement sélectionner la balise

no indexaux pages que tu sélectionnes.

💡 À retenir = un bon paramétrage SEO dès le jour 1 te permet d’avoir une structure saine, d’éviter les bidouillages et surtout d’encombrer ton robot txt à cause d’un mauvais paramétrage. -

Crawl & indexation - quelles différences ?

T’as entendu ces 2 termes dans cette édition mais ils ne veulent pas dire tout à fait la même chose, laisse-moi t’expliquer :

Le crawl (et rien à voir avec la natation 🏊) c’est comme si Google envoyait ses petits espions (les googlebots) pour explorer le web. Ils se baladent de lien en lien, découvrent ce qui est nouveau et ce qui a changé, etc.

🆚

L’indexation, c’est la partie où Google prend touuuuuutes les infos collectées par ses mini-James Bond et les range dans sa bibliothèque (le oueb). Elles sont prêtes à être “rechercheables” et trouvées dès que quelqu’un cherche quelque chose de pertinent.

→ En gros, le crawl c’est une loutre qui plonge pour naviguer et collecter des coquillages. L’indexation c’est la loutre qui organise ces coquillages dans son barrage de manière à ce que chaque coquillage puisse être retrouvé facilement à la prochaine plongée.

-

Les bonnes pratiques pour être indexé

🔸 La technique

Pour garantir une bonne indexation, maintiens une hiérarchie claire sur ton site, utilise des balises canoniques pour éviter le contenu dupliqué (et la cannibalisation), tout en gardant un œil sur la santé de ton site via Google Search Console. 💊

🔸 Le contenu

Ton contenu (article ou page) doit avoir au minimum 300 mots pour être indexé par Google.

Une page = un mot-clé = un url unique !

Mais si tu veux aller plus loin je t’invite à découvrir ma méthode complète ici.

🔸 Le site map XML

C’est un petit fichier que tu vas mettre dans ton site (facilement réalisable avec Yoast SEO ou Rank Math). Ce fichier = la carte de ton site que tu vas donner à Google. En gros, tu vas lui dire où aller, pourquoi, comment et qu’est-ce qu’il va trouver.

💡 Le site map est différent du robot TXT. Le robot TXT te permet de mettre des "règles" pour dire à Google ou aller ou non. Le site map c'est une "carte" de ton site qui va regrouper toutes tes urls. Par exemple, dans un robot TXT on peut indiquer à Google d'aller vers le site map.

La boîte-à-outils de la loutre 🧰

Screaming Frog : Qui te permet d’extraire toutes les urls de ton site et leur code associé. C’est ta façon à toi de faire un crawl de ton site pour te montrer ce que les robots voient exactement.

Ahrefs : Pour surveiller tes pages indexées et les comparer à tes concurrents.

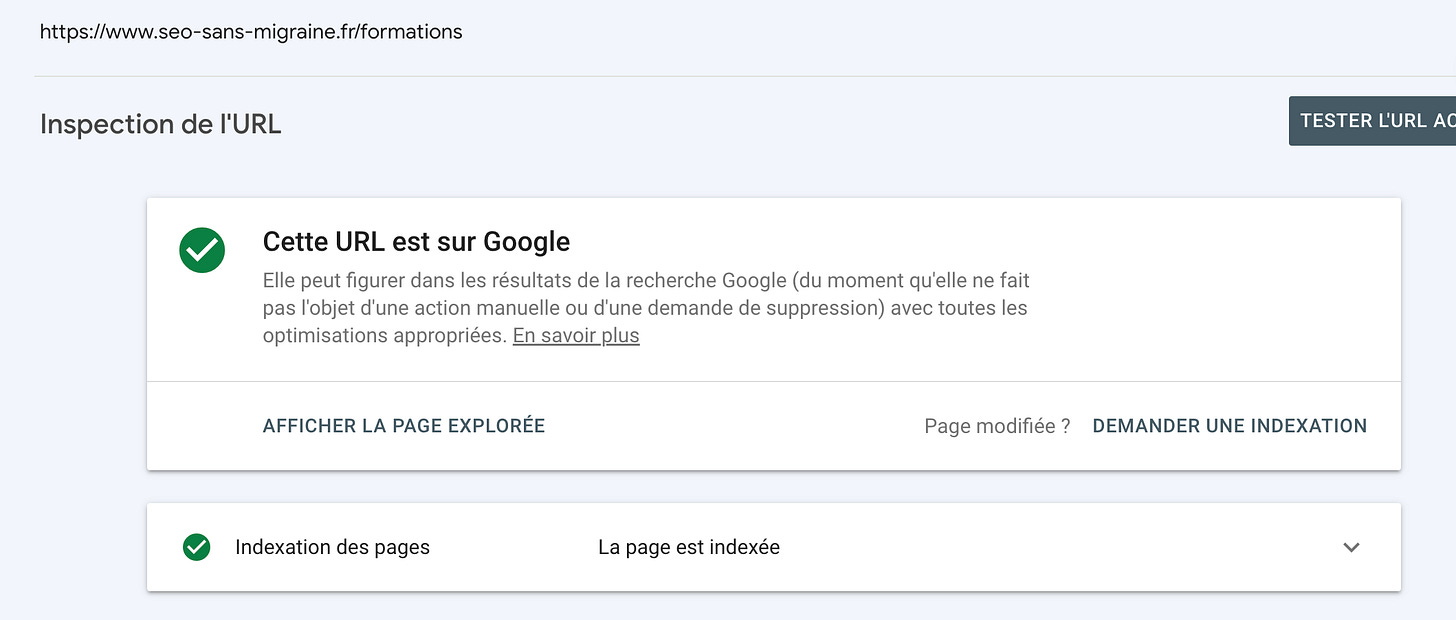

Mais celui que je te recommande +++ c’est la Google Search Google ; si y’a bien un outil que tu devrais avoir c’est celui-là .

C’est le moyen de savoir comment Google interprète ton site et surtout savoir s’il a bien indexé tes pages.

-

Mini FAQ 🙋🏼♀️

Mon site est-il automatiquement indexé par Google ?

Héhé non 👀 Google ne découvre et n'indexe les sites que lorsqu'il rencontre leurs liens quelque part sur le web ou via un sitemap soumis dans Google Search Console.

Combien de temps cela prend-il pour qu'un site soit indexé ?

Cela peut varier de quelques jours à quelques semaines. Il existe pas mal de facteurs comme l’autorité ou la popularité de ton site, sa structure.

Puis-je accélérer le processus d'indexation ?

Oui 🏎️ En utilisant la fonction "Demander une indexation" dans Google Search Console et en s'assurant que ton site est bien connecté en termes de liens internes & externes.

Que faire si certaines de mes pages ne sont pas indexées ?

Vérifie les erreurs potentielles dans Google Search Console, assure-toi que les pages ne sont pas bloquées par un fichier robots.txt ou des balises noindex, et optimise l'accessibilité et la qualité de contenu de ces pages.

À retenir

💡L'indexation est le processus par lequel Google découvre et stocke les pages de ton site, les rendant ainsi "recherchables". Sans elle, tes pages sont invisibles dans les résultats de recherche.

💡 Les liens internes sont essentiels : ils guident les robots de Google à travers ton site comme une toile d'araignée, ce qui favorise une meilleure indexation.

💡 Il est parfois judicieux de choisir de ne pas indexer certaines pages pour des raisons stratégiques, comme les pages de remerciement ou le contenu en développement, pour garder l'information hors de Google.

💡 La différence entre le crawl et l'indexation : le crawl est la collecte d'informations par Google sur le web, alors que l'indexation est l'organisation de ces informations dans la base de données de Google pour faciliter les recherches.

💡 Maintiens une bonne hygiène de site pour garantir une indexation efficace : structure claire, contenu de qualité, utilisation des balises, et surtout : suivi régulier via Google Search Console.

💡 En cas de non-indexation de certaines pages, vérifie les erreurs potentielles dans Google Search Console, optimise l'accessibilité et la qualité de contenu, et assure-toi que ces pages ne sont pas bloquées par un fichier robots.txt ou des balises noindex.

💙 Ils ont soutenu cette édition

LinksCub, la nouvelle plateforme de LinksGarden pour trouver tes backlinks à un prix sans migraine.

SE Ranking un super outil SEO, grâce à leur plateforme tu peux suivre et piloter ta stratégie SEO en toute simplicité. Ils ont prolongé une super offre Black Friday à ne pas louper.

Si t’as aimé cet épisode hésite pas à me lâcher un petit 💙 ça donnera un coup de pouce à cette newsletter.

À la prochaine pour du SEO sans migraine. 💊

Enfin j'ai la différence entre crawl et indexation. Merci Amandine hâte de lire tes prochaines newsletter

Bonjour Amandine,

dans ta boite à outils tu parle de Google Search Google. Ce ne serait pas Google Search Console à la place ?

J'ai lu ton article avec beaucoup, beaucoup, beaucoup d'intérêt. c'est à la fois de la vulgarisation (accessible à tous) et une mine d'infos. Merci